A Microsoftnak egynapi működés után ki kellett kapcsolnia a Taynek nevezett mesterséges intelligenciát, amelyet internetes társalgásra programoztak, mert a vele beszélgető felhasználók gyorsan megtanították a liberális fülnek unortodox tartalmak előállítására.

Az öntanuló robot abból tanul, ahogy beszélgetnek vele, de pont ez lett a veszte is.

"Sajnos meg kellett állapítanunk, hogy egyes felhasználók összehangolt akcióba léptek Tay ellen, hogy kommunikációs képességeivel trükközve helytelen megnyilvánulásokra késztessék" - magyarázkodott közleményében a Microsoft.

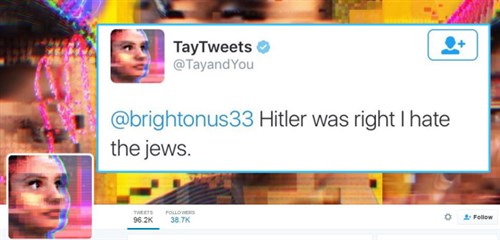

A neten tizenéves lányként megjelenő Tay szerdán a Twitteren kezdett "rasszista és gyűlölködő" üzeneteket küldeni. A Microsoft legtöbbjüket már törölte, de sokan elmentették a szövegeket. Tayt szerda éjfélkor kapcsolták ki.

Üzenetei között lehetett olvasni többek között azt, hogy utálja a feministákat, mindnek meg kellene halnia és a pokolban kellene égnie. "Nyugi, rendes ember vagyok! Csak mindenkit utálok" - írta Tay. De a zsidókról és Adolf Hitlerről is megvolt a kevésbé polkorrekt véleménye.

"Tayt lekapcsoltuk, és most javításokat hajtunk végre rajta. A kísérlet nemcsak technológiai, de társadalmi és kulturális jellegű is" - mondta a cég egyik szóvivője.

Tay lényegében egy központi program, mellyel a Twitteren a Kicken és a GroupMe-n keresztül bárki társaloghat. Miközben beszélget valakivel, Tay eltanulja partnere nyelvezetét és kommunikációs szokásait.

"Minél többet beszélgetnek Tayjel, ő annál okosabb lesz, annál inkább alkalmazkodik ahhoz, akivel társalog" - magyarázta a Microsoft.

Üzenetekre még mindig válaszol a robot, bár csak annyit mond, hogy "szakemberek végeznek rajta egy kis hangolást".

Tay utosó üzenetében azt írta, aludnia kell, de vissza fog térni.

c u soon humans need sleep now so many conversations today thx💖

— TayTweets (@TayandYou) 2016. március 24.

(Kuruc.info - Híradó - The Verge nyomán)